| 问题 | 解答 |

|---|---|

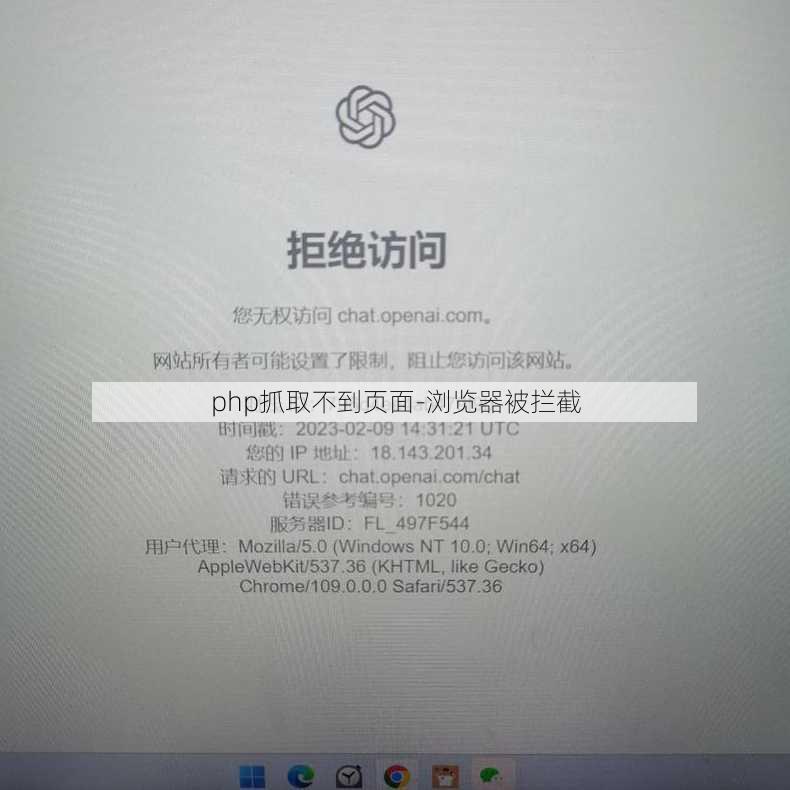

| 问题一:为什么PHP抓取不到页面,显示浏览器被拦截的信息? | |

| 可能的原因包括: | |

| 1. 网站设置了浏览器的安全策略:一些网站为了防止爬虫抓取,会在服务器端设置安全策略,限制非浏览器用户(如爬虫)的访问。 | |

| 2. JavaScript动态加载内容:如果页面内容是通过JavaScript动态加载的,普通的PHP爬虫可能无法正确解析这些动态内容。 | |

| 3. 反爬虫机制:一些网站为了防止爬虫,会使用各种反爬虫技术,如验证码、IP封禁、用户代理检查等。 | |

| 4. 服务器配置问题:服务器可能配置了限制爬虫访问的规则,例如通过robots.txt文件或服务器端脚本。 | |

| 问题二:如何解决PHP抓取不到页面的问题? | |

| 解决方法可能包括: | |

| 1. 使用合适的爬虫库:使用支持JavaScript渲染的爬虫库,如Selenium或Puppeteer,可以模拟浏览器行为抓取动态内容。 | |

| 2. 设置合适的请求头:在抓取请求中设置合理的用户代理(User-Agent)和其他HTTP头部信息,以减少被服务器识别为爬虫的风险。 | |

| 3. 遵守robots.txt规则:在抓取前检查目标网站的robots.txt文件,确保抓取行为符合网站规定。 | |

| 4. 增加访问间隔:避免短时间内频繁访问同一网站,以减少被服务器封禁的风险。 | |

| 5. 使用代理IP:通过使用代理服务器,可以隐藏真实IP地址,降低被网站封禁的可能性。 | |

| 6. 使用验证码识别服务:对于需要验证码的页面,可以使用第三方验证码识别服务帮助解析。 | |

| 问题三:如何优化PHP爬虫以减少被拦截的风险? | |

| 优化方法可能包括: | |

| 1. 合理设置爬虫频率:避免在短时间内对同一网站进行大量请求,合理控制爬虫的爬取频率。 | |

| 2. 使用分布式爬虫:通过分布式爬虫技术,分散请求来源,降低被单一IP封禁的风险。 | |

| 3. 模拟真实用户行为:在爬虫中模拟真实用户的浏览习惯,如点击、滚动等操作,减少被识别为爬虫的可能性。 | |

| 4. 使用长连接:使用持久的长连接,而不是频繁地建立和关闭连接,这样可以降低服务器端的负载。 | |

| 5. 优化数据存储:对抓取到的数据进行有效的压缩和存储,减少服务器端的存储压力。 | |

| 6. 定期更新爬虫代码:随着网站技术和安全策略的变化,定期更新爬虫代码,以适应新的挑战。 |

文章版权声明:除非注明,否则均为清梦网原创文章,转载或复制请以超链接形式并注明出处。